https://huggingface.co/blog/zh/moe

MoE 示例:

import torch

import torch.nn as nn

import torch.nn.functional as F

# 定义单个专家网络

class Expert(nn.Module):

def __init__(self, input_dim, hidden_dim, output_dim):

super(Expert, self).__init__()

self.layer1 = nn.Linear(input_dim, hidden_dim)

self.layer2 = nn.Linear(hidden_dim, output_dim)

def forward(self, x):

x = F.relu(self.layer1(x))

x = self.layer2(x)

return x

# 定义门控网络

class Gate(nn.Module):

def __init__(self, input_dim, num_experts):

super(Gate, self).__init__()

self.layer = nn.Linear(input_dim, num_experts)

def forward(self, x):

return F.softmax(self.layer(x), dim=-1)

# 定义 MoE 模型

class MixtureOfExperts(nn.Module):

def __init__(self, input_dim, hidden_dim, output_dim, num_experts):

super(MixtureOfExperts, self).__init__()

# 初始化多个专家

self.experts = nn.ModuleList([

Expert(input_dim, hidden_dim, output_dim)

for _ in range(num_experts)

])

# 初始化门控网络

self.gate = Gate(input_dim, num_experts)

self.num_experts = num_experts

def forward(self, x):

# 获取门控输出 (batch_size, num_experts)

gate_output = self.gate(x)

# 获取每个专家的输出 (batch_size, output_dim, num_experts)

expert_outputs = torch.stack([expert(x) for expert in self.experts], dim=2)

# 加权组合专家输出 (batch_size, output_dim)

output = torch.einsum('be,bde->bd', gate_output, expert_outputs)

return output

# 测试代码

def main():

# 设置参数

input_dim = 10

hidden_dim = 20

output_dim = 5

num_experts = 3

batch_size = 32

# 创建模型

model = MixtureOfExperts(input_dim, hidden_dim, output_dim, num_experts)

# 生成随机输入数据

x = torch.randn(batch_size, input_dim)

# 前向传播

output = model(x)

print(f"Input shape: {x.shape}")

print(f"Output shape: {output.shape}")

print(f"Sample output: {output[0]}")

if __name__ == "__main__":

# 检查是否有 GPU

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

print(f"Using device: {device}")

main()

代码说明:

Expert类: 定义了一个简单的两层神经网络作为专家模型。Gate类: 定义了门控网络,用于为每个输入分配专家的权重。MixtureOfExperts类: 组合了多个专家和一个门控网络,通过加权求和得到最终输出。main函数: 测试代码,创建模型并运行一个随机输入。

输出示例:

运行代码后,你会看到类似以下的输出:

Using device: cpu

Input shape: torch.Size([32, 10])

Output shape: torch.Size([32, 5])

Sample output: tensor([ 0.1234, -0.5678, 0.9101, -0.2345, 0.6789])

注意事项:

- 这个实现是一个基础版本,实际应用中可能需要添加正则化、噪声(如在门控网络中加入 Gumbel-Softmax)或更复杂的专家结构。

什么是混合专家模型?

模型规模是提升模型性能的关键因素之一。在有限的计算资源预算下,用更少的训练步数训练一个更大的模型,往往比用更多的步数训练一个较小的模型效果更佳。

混合专家模型 (MoE) 的一个显著优势是它们能够在远少于稠密模型所需的计算资源下进行有效的预训练。这意味着在相同的计算预算条件下,您可以显著扩大模型或数据集的规模。特别是在预训练阶段,与稠密模型相比,混合专家模型通常能够更快地达到相同的质量水平。

那么,究竟什么是一个混合专家模型 (MoE) 呢?作为一种基于 Transformer 架构的模型,混合专家模型主要由两个关键部分组成:

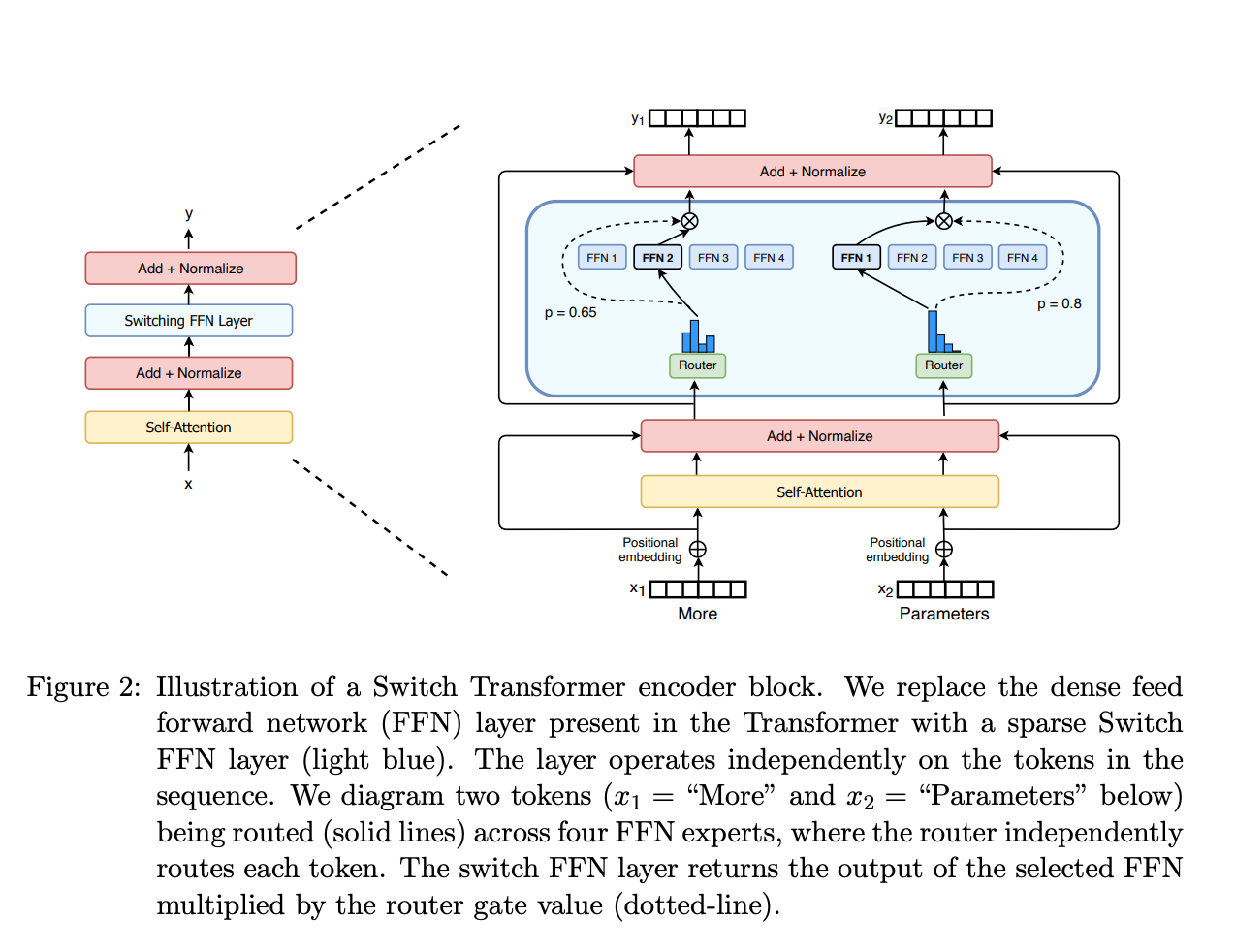

稀疏 MoE 层: 这些层代替了传统 Transformer 模型中的前馈网络 (FFN) 层。MoE 层包含若干“专家”(例如 8 个),每个专家本身是一个独立的神经网络。在实际应用中,这些专家通常是前馈网络 (FFN),但它们也可以是更复杂的网络结构,甚至可以是 MoE 层本身,从而形成层级式的 MoE 结构。 门控网络或路由: 这个部分用于决定哪些令牌 (token) 被发送到哪个专家。例如,在下图中,“More”这个令牌可能被发送到第二个专家,而“Parameters”这个令牌被发送到第一个专家。有时,一个令牌甚至可以被发送到多个专家。令牌的路由方式是 MoE 使用中的一个关键点,因为路由器由学习的参数组成,并且与网络的其他部分一同进行预训练。

Switch Transformers paper 论文中的 MoE layer

总结来说,在混合专家模型 (MoE) 中,我们将传统 Transformer 模型中的每个前馈网络 (FFN) 层替换为 MoE 层,其中 MoE 层由两个核心部分组成: 一个门控网络和若干数量的专家。

Switch Transformers paper 论文中的 MoE layer

总结来说,在混合专家模型 (MoE) 中,我们将传统 Transformer 模型中的每个前馈网络 (FFN) 层替换为 MoE 层,其中 MoE 层由两个核心部分组成: 一个门控网络和若干数量的专家。

尽管混合专家模型 (MoE) 提供了若干显著优势,例如更高效的预训练和与稠密模型相比更快的推理速度,但它们也伴随着一些挑战:

训练挑战: 虽然 MoE 能够实现更高效的计算预训练,但它们在微调阶段往往面临泛化能力不足的问题,长期以来易于引发过拟合现象。 推理挑战: MoE 模型虽然可能拥有大量参数,但在推理过程中只使用其中的一部分,这使得它们的推理速度快于具有相同数量参数的稠密模型。然而,这种模型需要将所有参数加载到内存中,因此对内存的需求非常高。以 Mixtral 8x7B 这样的 MoE 为例,需要足够的 VRAM 来容纳一个 47B 参数的稠密模型。之所以是 47B 而不是 8 x 7B = 56B,是因为在 MoE 模型中,只有 FFN 层被视为独立的专家,而模型的其他参数是共享的。此外,假设每个令牌只使用两个专家,那么推理速度 (以 FLOPs 计算) 类似于使用 12B 模型 (而不是 14B 模型),因为虽然它进行了 2x7B 的矩阵乘法计算,但某些层是共享的。 了解了 MoE 的基本概念后,让我们进一步探索推动这类模型发展的研究。

开源混合专家模型

目前,下面这些开源项目可以用于训练混合专家模型 (MoE):

Megablocks: https://github.com/stanford-futuredata/megablocks Fairseq: https://github.com/facebookresearch/fairseq/tree/main/examples/moe_lm OpenMoE: https://github.com/XueFuzhao/OpenMoE 对于开源的混合专家模型 (MoE),你可以关注下面这些:

Switch Transformers (Google): 基于 T5 的 MoE 集合,专家数量从 8 名到 2048 名。最大的模型有 1.6 万亿个参数。 NLLB MoE (Meta): NLLB 翻译模型的一个 MoE 变体。 OpenMoE: 社区对基于 Llama 的模型的 MoE 尝试。 Mixtral 8x7B (Mistral): 一个性能超越了 Llama 2 70B 的高质量混合专家模型,并且具有更快的推理速度。此外,还发布了一个经过指令微调的模型。有关更多信息,可以在 Mistral 的 公告博客文章 中了解。